top of page

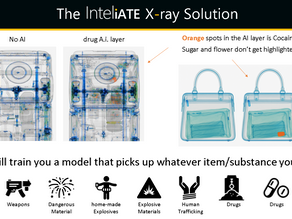

Intelligence sui container/raggi X: confronta il carico con le dichiarazioni

La revisione manuale dei raggi X è lenta e incoerente; molti contenitori passano senza controllo e la documentazione spesso non corrisponde a ciò che è contenuto al loro interno. I modelli on-premise e offline di InteliATE leggono la dichiarazione , analizzano i raggi X , contano gli articoli e segnalano le discrepanze con risultati verdi/gialli/rossi e report di prova, in modo che i team agiscano più rapidamente, proteggendo al contempo i ricavi e bloccando il contrabba

LLM sovrani on-prem: personalizzati in base alla tua lingua, al tuo flusso di lavoro e alla tua giurisdizione

Perché i team scelgono LLM sovrani e on-prem Se i tuoi dati sono investigativi, regolamentati o sensibili alla sicurezza, l'intelligenza artificiale nel cloud è spesso una scelta inutile. Con Inteliate, i modelli vengono installati in sede , eseguiti offline/air-gapped e utilizzano crittografia end-to-end e role-ba. accesso sed e registri di controllo completi, in modo che nulla esca dalla tua rete o giurisdizione. Personalizziamo e distribuiamo modelli di intelligenza ar

LLM autoadattanti, modelli linguistici: il modello on-premise per un apprendimento sicuro e continuo

Cos'è un LLM autoadattativo (in pratica)? Un LLM autoadattante è un modello distribuito localmente che (1) viene addestrato in modo personalizzato sui tuoi dati ; (2) viene costantemente migliorato con il feedback degli operatori e nuovi esempi; e (3) viene eseguito completamente all'interno della tua rete , spesso in modalità air gap , in modo che non si verifichi alcuna trasmissione esterna . Non è un chatbot cloud generico; è un modello sovrano legato ai tuoi fascic

bottom of page